IA Act et RGPD

Article d'Expert

IA Act et RGPD Pour une IA respectueuse de ses utilisateurs

L’Intelligence artificielle s’est très largement développée ces dernières années : elle s’est perfectionnée et ses usages sont désormais multiples.

Est également venu son lot d’abus et de polémiques à travers le monde : surcouches algorithmiques sur les caméras de vidéoprotection permettant la reconnaissance faciale, score social en Chine, discussions autour des œuvres produites par les IA et des droits d’auteur, etc…

L’objectif de l’IA Act est de permettre le déploiement et le développement de systèmes d’IA respectueux des droits des citoyens européens et d’encadrer, voire d’interdire, certaines dérives, en complément de réglementations déjà existantes.

Au vu des réglementations qui entourent l’IA, à quoi ressemble une IA respectueuse des droits de ses utilisateurs ?

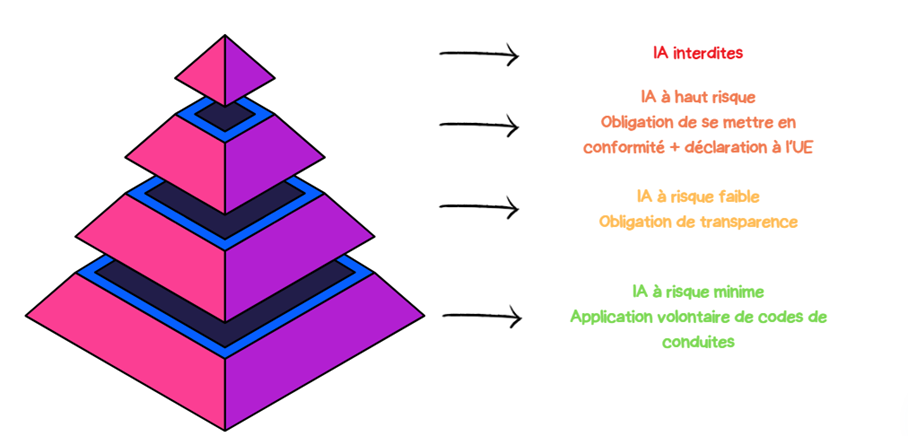

Si certains systèmes d’IA sont interdits, les IA catégorisées « à haut risque » voient peser sur elles de lourdes obligations.

1. Les IA Interdites

Alors que le RGPD n’a pas vocation à purement et simplement interdire des traitements de données, la philosophie de l’IA Act semble plus sévère.

En effet, ce texte interdit catégoriquement des systèmes d’IA sur la base de l’intention donnée derrière son déploiement. Par exemple, les IA visant à développer des techniques subliminales pour altérer le comportement et la prise de décision d’une personne sont interdites.

D’autres systèmes, en revanche, bénéficient d’une interdiction qu’il est possible de contourner en se référant à des exceptions bien définies, comme le prévoit le RGPD concernant les traitements des données « hautement personnelles » ou « sensibles » par exemple.

C’est le cas de l’IA destinée à créer un score social, qui sera interdite uniquement dans ces deux cas :

· Si le score social effectue un traitement défavorable aux personnes dans des contextes sociaux qui ne correspondent pas aux contextes dans lesquels les données ont été collectées ;

· Si le score social débouche sur un traitement défavorable ou préjudiciable pour les personnes concernées, de manière disproportionnée par rapport à leurs actes.

Également, la reconnaissance faciale via les caméras de vidéoprotection est en principe interdite, sauf lorsqu’elle poursuit l’objectif clairement défini d’opérer des recherches de personnes ciblées.

Il sera aussi possible de l’utiliser, de manière limitée, pour prévenir des menaces actuelles, réelles et prévisibles d’attaque terroriste.

Le texte vise donc à limiter l’utilisation de ces systèmes aussi bien dans le temps que dans leur pratique afin d’éviter leur généralisation. Sur ce point, un rappel direct au RGPD est fait puisque l’identification via reconnaissance faciale constitue un traitement de données sensibles tel que défini à l’article 9 du texte.

Des sanctions sont prévues en cas d’utilisation d’un système d’IA non autorisé (avec des montants plus élevés que ceux affichés dans le RGPD ) :

- Amende administrative pouvant aller jusqu’à 35 000 000 d’euros (contre 20 000 000 d’euros maximum pour le RGPD) ou ;

- 7% du chiffre d’affaires annuel mondial (contre 4% du chiffre d’affaires mondial maximum pour le RGPD).

2. Les IA à haut risque

Pêle-mêle, sont notamment concernées les IA suivantes :

· Reconnaissance des émotions,

· Évaluation des élèves lors d’un apprentissage,

· Aide au recrutement,

· Évaluation des salariés,

· Score crédit et solvabilité,

· Évaluation du risque de récidive d’une infraction pénale,

· Aide à l’examen des demandes d’asile,

· Opération d’influence dans les résultats d’élections et de référendums.

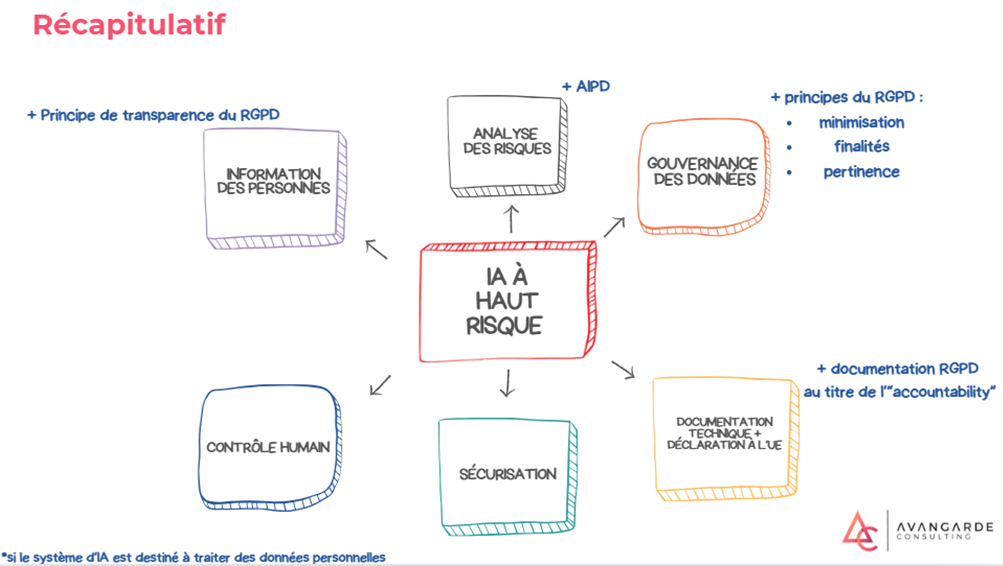

Afin de respecter l’IA Act, les entreprises se doivent désormais de classer leurs développements en matière d’IA selon différents niveaux de risque, cette démarche devant être complétée par la production d’évaluations d’impact de ces risques. Les entreprises doivent également désormais s’astreindre à adopter un système de gouvernance des données.

Evaluer les risques

Pour ces systèmes d’IA, une évaluation des risques pouvant exister sur la santé, la sécurité et les droits fondamentaux des personnes sera obligatoire. Ce processus d’évaluation doit s’effectuer de manière continue pendant toute la vie du système d’IA et doit obligatoirement être revu et mis à jour régulièrement.

Le RGPD est directement mentionné ici puisque les systèmes d’IA peuvent être soumis à l’obligation de mener une Analyse d’Impact relative à la protection des données personnelles (AIPD - article 35 du RGPD).

L’analyse de risque prévue par l’IA Act doit compléter l’analyse d’impact sur la protection des données, afin de ne pas ajouter de surcouches procédurales contre-productives.

À la suite de cette évaluation, des mesures d’atténuation des risques doivent être prises, jusqu’à ce que les risques résiduels soient jugés acceptables.

Sur la pertinence de mener des AIPD, la CNIL précise que les critères justifiant l’obligation de conduire une AIPD seraient le fait que les traitements d’IA constitueraient :

- Un traitement de données personnelles innovant

- Un traitement de donnée à large échelle.

Elle précise que dans les deux cas une approche contextuelle doit avoir lieu : une IA serait un traitement dit « innovant » en fonction d’une part des technologies utilisées par le responsable de traitement avant qu’il se décide à utiliser de l’IA, et d’autre part de son niveau de maturité.

Enfin, la CNIL rappelle que les IA fondées sur du deep learning seront considérées comme étant des IA effectuant des traitements innovants.

Adopter un système de gouvernance des données

En plus de cette approche par les risques, les concepteurs d’IA doivent adopter un système de gouvernance des données qui vise à faire en sorte que les données soient notamment :

· Pertinentes,

· Que des hypothèses soient formulées sur ce que les données sont censées mesurer,

· Disponibles en bonne quantité,

· Examinées en vue de prévenir les éventuels biais.

Doivent s’ajouter à ces principes afin de prévoir une collecte de données respectueuse des droits fondamentaux des personnes concernées prévus par le RGPD :

- La minimisation des données (ne collecter que ce qui est strictement nécessaire aux objectifs poursuivis),

- La limitation des durées de conservation (arbitrer une durée au-delà de laquelle les données doivent être supprimées ou anonymisées).

Des principes de transparence auprès des utilisateurs doivent également être mis en place afin de leur permettre d’appréhender au mieux le système d’IA et d’interpréter de la meilleure manière les résultats obtenus, notamment via un mode d’emploi mis à disposition.

Cette partie n’est pas sans rappeler les principes de loyauté et de transparence également présents dans le RGPD. Ainsi, lors de l’utilisation d’un système d’IA, devront être associés dans un corpus commun les éléments de l’IA Act et du RGPD.

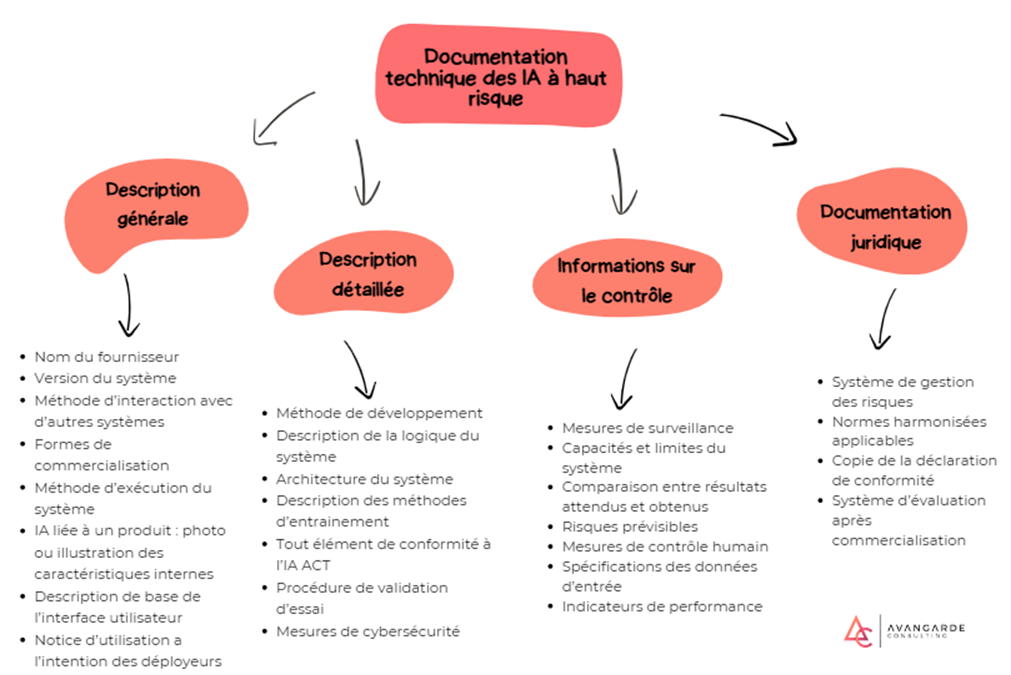

Ces processus doivent être documentés en interne afin de prouver leur mise en place, notamment dans le cas d’un contrôle. L’IA Act suit ici la même logique que le RGPD, appelée « accountability », obligeant les concepteurs et déployeurs d’IA à s’auto-responsabiliser et à présenter, au moment d’un contrôle, toute garantie de conformité.

Le non-respect des principes de contrôle des IA à haut risque peut générer une amende de 15 000 000 d’euros ou 3% du chiffre d’affaires annuel mondial.

Ces procédures doivent être documentées afin de prouver leur mise en place auprès des autorités de contrôle.

3. Autres catégories d’IA

IA à risque faible

Les IA à risque faible sont définies comme étant des IA interagissant directement avec leurs utilisateurs, et n’étant ni interdites, ni présentes dans la liste des IA à haut risque.

Cette catégorie d’IA est simplement soumise à une obligation de transparence, à laquelle s’ajoute l’obligation des articles 12 à 14 du RGPD si jamais cette dernière traite des données à caractère personnel.

Cette obligation d’information portera essentiellement sur le fait de porter à la connaissance de l’utilisateur le fait que celui-ci interagit avec une intelligence artificielle et non un être humain. De même concernant la création de contenu tels que des illustrations, des vidéos ou du son : il sera interdit de les publier sans faire clairement figurer que ces contenus ont été générés automatiquement.

IA à risque minime

Les IA à risque minime sont donc définies par élimination comme étant les autres systèmes d’IA, qui ne sont ni interdites, ni à haut risque, ni à risque faible. Au vu de la quasi-absence de risque pour ces systèmes, aucune obligation ne pèse sur les fournisseurs de ces systèmes. Ils auront simplement la possibilité d’appliquer des codes de conduite de manière volontaire et adaptée à leur système.

Ces codes de conduite seront encouragés par les autorités européennes et pourront être construits par des fournisseurs seuls ou en partenariat, que ce soit avec d’autres fournisseurs ou d’autres catégories d’acteur.

Cette démarche est également très similaire à ce que l’on trouve dans le RGPD qui prévoit également l’élaboration de codes de conduite afin de faciliter la mise en conformité avec la réglementation sur la protection des données.

IA à usage général

Les catégories d’IA exposées précédemment concernent surtout les systèmes dont l’utilité est connue et définie dès le départ de la phase de développement. Mais subsiste encore le problème des systèmes d’IA dont le développement est lancé, mais dont l’utilisation reste inconnue tant que l’IA n’est pas déployée. Il s’agit de l’IA à usage général.

Etant donné que l’utilité du système est inconnue pendant la phase de développement, les risques qui peuvent être soulevés le sont également. S’il est compliqué de définir le niveau de risque pendant cette phase, il sera donc difficile de savoir s’il est nécessaire ou non d’appliquer les mêmes exigences de conformité qu’un modèle d’IA à haut risque.

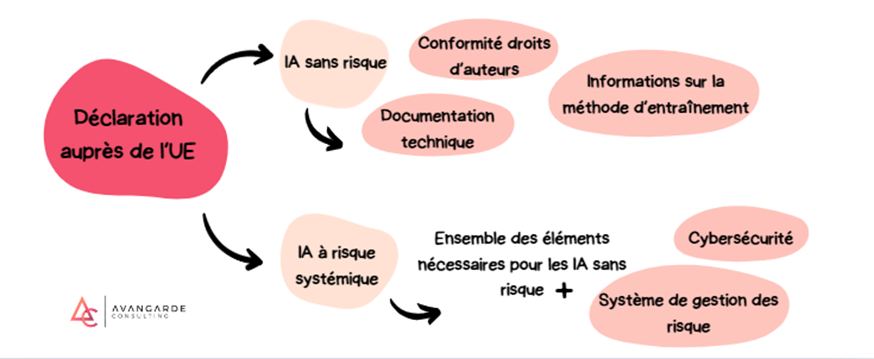

L’IA Act a déterminé de définir le niveau de risque d’une IA générale en fonction de sa puissance de calcul. Si cette dernière se situe au-dessus de 10^25 FLOPS (unité de mesure de la rapidité de calcul d’un système informatique), l’IA sera considérée comme présentant un risque “systémique”.

4. Soutiens à l’innovation

Bacs à sable réglementaires

La mise en place de bacs à sable réglementaires est désormais une pratique courante lors de l’adoption d’une régulation d’un domaine considéré comme innovant. Ces dispositifs permettent aux acteurs du secteur de développer leur projet en étant encadré de bout en bout par le régulateur lui-même. Cela favorise les expérimentations et l’innovation puisque les acteurs peuvent développer leur projet en s’affranchissant des réglementations applicables étant donné qu’ils évoluent dans un cadre bien défini et surveillé.

L’IA Act encourage les autorités nationales à mettre en place des bacs à sable réglementaires destinés à permettre aux petits et moyens acteurs de l’IA de développer leur projet de manière encadrée et en concordance avec les principes de l’IA Act et des autres réglementations applicables.

Cette mesure permet donc de réduire la charge réglementaire sur les PME et les start-ups souhaitant se lancer dans l’intelligence artificielle, ce qui s’avère particulièrement pertinent pour le développement d’IA à haut risque sur lesquelles pèsent de lourdes obligations.

Conclusion

A l’instar du RGPD, l’IA Act a fait parler de lui comme étant une réglementation freinant l’innovation et s'opposant frontalement aux principaux acteurs du marché.

Si certaines contraintes pour se mettre en conformité avec ce texte peuvent être lourdes, elles sont à chaque fois justifiées par une nécessité de protéger les utilisateurs et d’éviter que des dérives se généralisent, aussi bien de la part des acteurs privés que des autorités publiques.

L’IA Act n’étant pas à ce jour en application, nous ne savons pas encore quel organisme aura la charge d’effectuer ces contrôles et de recevoir les plaintes des utilisateurs.

L’attribution de cette tâche, en France, à la CNIL, pourrait être pertinente, tant elle produit déjà des recommandations pointues sur l’usage de l’IA et les conséquences de l’IA Act, tandis que de son côté, l’IA Act adopte une philosophie similaire au RGPD jusqu’à le mentionner directement à plusieurs reprises.

L’IA Act nous indique que l’Intelligence Artificielle est - et doit rester - un outil au service des besoins des individus, d’où la nécessité d'une régulation qui impose des contraintes fortes sur des secteurs sensibles, et qui, dans le même temps, favorise et encourage le développement des IA en facilitant les projets des petits et moyens acteurs.

Il est assez clair que l’objectif derrière ce texte est de permettre, à terme, d’utiliser la conformité comme un avantage concurrentiel pour les développeurs et intégrateurs de systèmes d’IA, tout comme le RGPD : nous commençons ainsi à identifier des avantages économiques clairs pour les acteurs ayant adopté une solide posture de conformité.

Simon Lucas , Consultant Privacy Avangarde Consulting

Références :

Guide d'auto-évaluation pour les systèmes d'intelligence artificielle (IA) | CNIL

Les fiches pratiques IA | CNIL